在语法上的引擎盖下:与AI一起检测杂乱无章的写作

已发表: 2018-07-10每当您写一些比句子更长的东西时,您都需要就如何组织和提出您的想法做出决定。好的写作很容易理解,因为每个句子都建立在之前的句子上。当主题发生变化时,强大的作家使用过渡句子和段落中断作为路标,以告诉读者下一步会有什么期望。

语言学家称之为写作话语连贯性的这一方面,这是语法研究团队的一些很酷的新研究的主题,该研究将在本周在澳大利亚墨尔本举行的Sigdial会议上出现。

什么是一致性的,为什么要关心它?

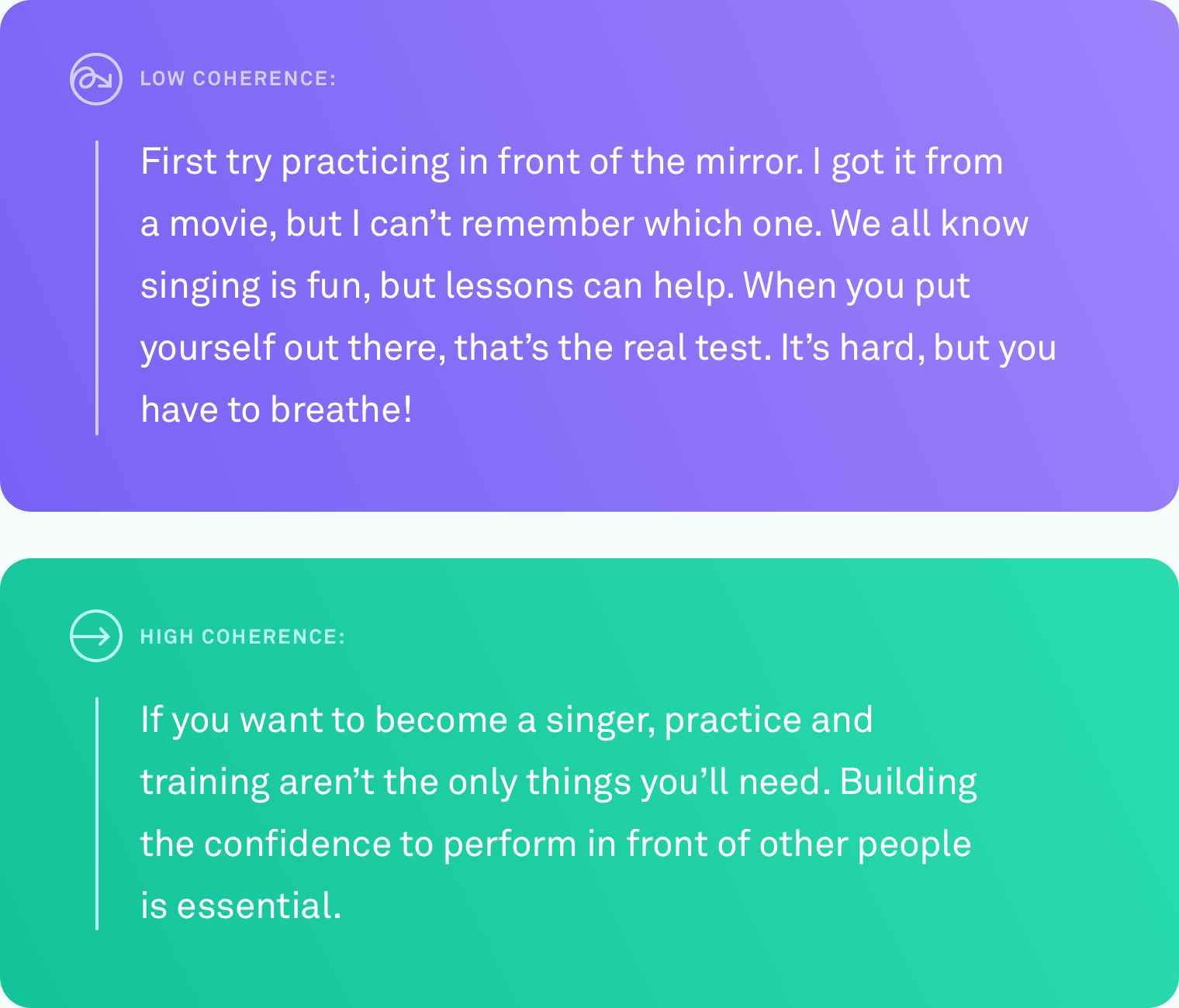

当我们说文本具有很高的话语连贯性时,我们的意思是所有句子都逻辑上链接在一起。作者不会偏离主题。不同点通过过渡连接。本文从头到尾都很容易遵循。

这种类型的组织并不总是自然而然的。我们很少有人在思想的完美线性发展中思考。一个可以自动告诉您的系统何时写一些其他人会努力遵循,并最终建议如何解决此问题,这将非常有帮助,以传达您的意思。

做了什么

教计算机以准确判断文本的连贯性水平是具有挑战性的。迄今为止,评估计算机费用话语一致性的最常见方法是基于句子订购任务。通过这种方法,研究人员会采用现有的,经过良好编辑的文本,例如新闻文章,并随机重新排序所有句子。假设是可以将随机排列视为不一致的,并且可以将原始订购视为连贯。任务是构建一个可以区分不一致版本和原始版本的计算机算法。在这些条件下,某些系统的精度高达90%。令人印象深刻。

但是这种方法存在很大的潜在缺陷。也许您已经发现了它。随机重新排序的句子可能会产生低相连的文本,但不会产生看起来像人类自然写的任何东西的文本。

在Grammarly,我们专注于解决现实世界中的问题,因此我们知道,我们在这一领域所做的任何工作都需要根据真实写作而不是人工场景进行基准测试。令人惊讶的是,在普通情况下,人们对人撰写的真实文本的话语评估方法很少。是时候改变了。

现实世界研究,现实世界作家

我们必须解决的第一个问题与其他每个从事话语连贯性的研究人员面临的问题相同:缺乏现实世界数据。我们没有现有的普通,自然写的文本语料库,我们可以测试我们的算法。

我们通过从几个公共资源中收集文字来创建一个语料库:雅虎答案,Yelp评论以及公开可用的政府和公司电子邮件。我们之所以选择这些特定的来源,是因为它们代表了人们在典型的一天中写的内容(Forum帖子,评论和电子邮件)。

为了将所有这些文本变成计算机算法可以学习的语料库,我们还需要对每个文本的相干级别进行评分。此过程称为注释。无论您的算法有多好,草率的注释都会大大偏向您的结果。在我们的论文中,我们提供了有关我们测试过的许多注释方法的详细信息,包括一些涉及众包的方法。我们最终决定让专家注释以三分尺度(低,中或高相干性)评价每个文本的相干水平。每个文本都由三个注释者判断。

将算法列入测试

一旦我们拥有语料库,就该测试各种计算机系统可以确定给定文本的连贯级别的准确程度。我们测试了三种类型的系统:

在第一类中是基于实体的模型。这些系统跟踪文本中提到相同实体的位置和频率。例如,如果系统在几个句子中找到“运输”一词,则将其视为这些句子在逻辑上相互关联的迹象。

在第二类中,我们测试了基于词汇相干图的模型。这是将句子表示为图中节点的一种方式,并连接包含一对相似单词的句子。例如,这种类型的模型将连接包含“汽车”的句子和一个包含“卡车”的句子,因为这两个句子都可能与车辆或运输有关。

第三类是神经网络或深度学习模型。我们测试了其中的几个,包括格拉马利团队建立的两种全新车型。这些是基于AI的系统,可以学习每个句子捕获其含义的表示,并且可以通过结合这些句子表示来了解文档的一般含义。他们可以寻找不限于实体出现或类似单词对的模式。

句子排序任务

我们使用了新语料库中的高稳态文本来为所有三种类型的模型创建句子订购任务。我们发现,在其他句子订购数据集上表现良好的模型在我们的数据集上也表现良好,其性能高达89%。基于实体的模型和词汇相干图显示了体面的准确性(通常为60%至70%的精度),但正是神经模型的表现使其他模型的表现在四个域中的三个域中的三个范围中至少高出10个百分点。

真正的写作测试

我们真正想知道的是,这些模型中的任何一个是否都可以在真实的,自然写的文本上以相同的准确性执行。我们将注释者的标签转换为数值(低= 1,中= 2,high = 3),并将数字平均在一起以获得每片文本的相干分数。

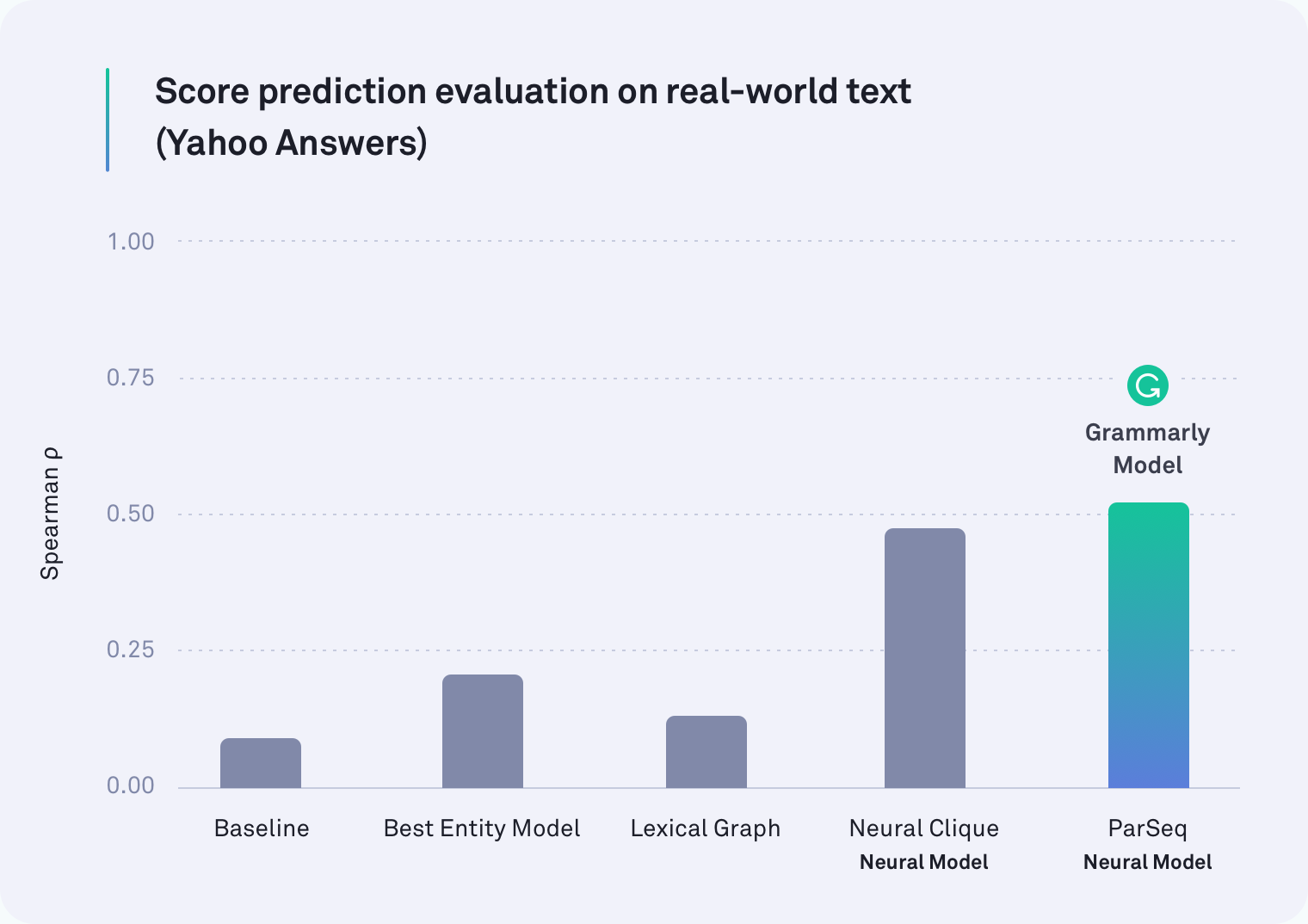

在每个域中,至少一个基于神经网络的系统的表现优于其他所有系统。实际上,考虑到段落中断的语法模型之一是Yahoo Answers的文本表现最好的,如下表所示。由斯坦福大学的研究人员开发的神经集团模型也是一个强大的表现。

但是我们最初的假设是正确的:所有模型在现实世界任务上的表现都比在句子顺序任务上所做的要差 - 有些更糟糕。例如,在人工句子重新排序方案中,词汇图方法对于公司电子邮件的准确性为78%,但在这种更现实的评估中,它仅设法实现了45%。

我们发现的

事实证明,以前关于话语连贯性的工作一直在测试错误的事情。句子顺序任务绝对不是衡量话语连贯性的好代理。我们的结果很明确:在人工场景中表现良好的系统在现实世界文本上会更糟。

重要的是要注意,这一发现不是挫折。实际上,远非如此。任何领域发展的一部分是在评估您的评估方式 - 不时地漫步,以查看您真正衡量的内容。由于这项工作,从事话语一致性的研究人员现在有两个重要的信息。一个是洞察力,即句子排序任务不再应该是我们衡量准确性的方式。第二个是现实世界文本和新基准(我们的神经模型)的公开可用的语料库,可用于未来的研究。

期待

对于一个可以可靠地判断文本中的话语连贯性的系统,还有许多令人兴奋的应用程序还有更多的工作和许多令人兴奋的应用程序。有一天,这样的系统不仅可以告诉您您的总体信息有多连贯,而且还指出了可能很难遵循的特定段落。有一天,我们希望帮助您使这些段落更容易理解,以便您要说的话对收件人很清楚。

毕竟,Grammarly成为一名全面的交流助手的道路不仅仅是确保您的写作在语法上和风格上是准确的,而是要确保您按预期理解。

- -

Joel Tetreault是Grammarly的研究总监。爱丽丝·莱(Alice Lai)是伊利诺伊大学Urbana-Champaign大学的博士生,并且是Grammarly的研究实习生。这项研究将在2018年7月12日至14日在澳大利亚墨尔本举行的SIGDIAL 2018年度会议上发表。随附的研究论文,题为“野外的话语连贯:数据集,评估和方法”将在第19届专辑小组的年度会议论文集上发表。此博客文章中描述的数据集称为语法语言语料库连贯性,可以在此处免费下载。