Pod maską w Grammarly: Wykrywanie niezorganizowanego pisania z AI

Opublikowany: 2018-07-10Ilekroć piszesz coś dłużej niż zdanie, musisz podejmować decyzje dotyczące organizacji i przedstawienia swoich myśli. Dobre pisanie jest łatwe do zrozumienia, ponieważ każde zdanie opiera się na tych, które pojawiły się przed nim. Kiedy temat zmienia się, silni pisarze używają zdań przejściowych i przerw w akapitach jako znaków, aby powiedzieć czytelnikom, czego się spodziewać.

Lingwiści nazywają ten aspekt pisania dyskursu spójnej i jest to przedmiot kilku fajnych badań zespołu badawczego gramatycznego, który pojawi się na konferencji Sigdial w Melbourne w Australii.

Co to jest spójność dyskursu i po co o to troszczyć?

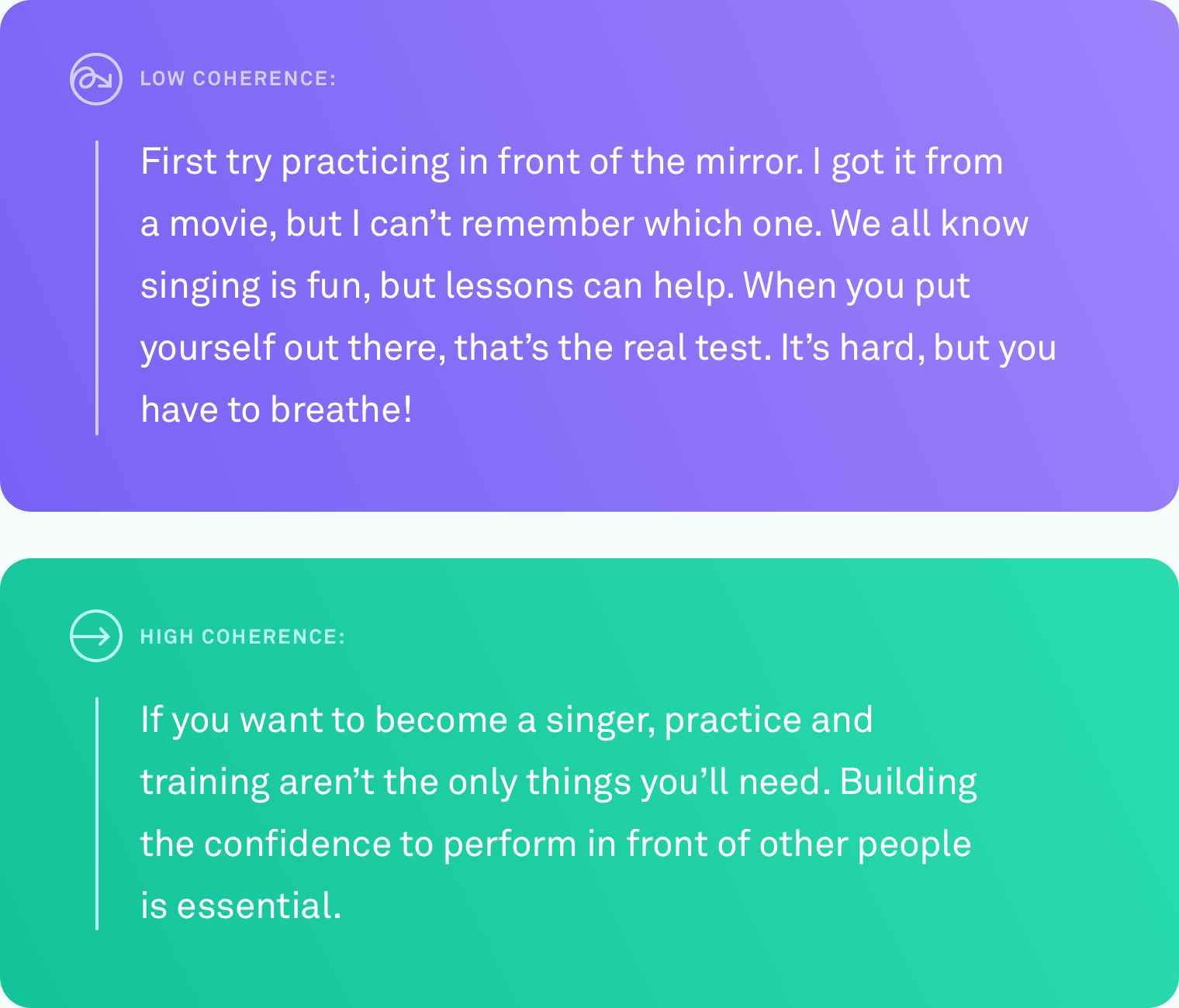

Kiedy mówimy, że tekst ma wysoki poziom spójności dyskursu, mamy na myśli, że wszystkie zdania są połączone logicznie. Pisarz nie zmniejsza tematu. Różne punkty są połączone przejściami. Tekst jest łatwy do naśladowania od początku do końca.

Ten rodzaj organizacji nie zawsze przychodzi naturalnie. Niewielu z nas myśli w doskonale liniowych postępach pomysłów. System, który mógłby automatycznie powiedzieć, kiedy napisasz coś, co inni ludzie będą miały trudności z śledzeniem - i ostatecznie sugerując, jak to naprawić - byłby niezwykle pomocny w przekazaniu tego, co masz na myśli.

Co zostało zrobione

Nauczenie komputera w celu dokładnego oceny poziomu spójności tekstu jest trudne. Do tej pory najczęstsza metoda oceny, w jaki sposób spójność dyskursu stawek komputerowych opiera się na zadaniu zamawiania zdania. Dzięki tej metodzie naukowcy biorą istniejący, dobrze zredagowany tekst, taki jak artykuł informacyjny, i losowo zamawiają wszystkie zdania. Zakłada się, że losowa permutacja może być postrzegana jako niespójna, a oryginalne zamówienie może być postrzegane jako spójne. Zadaniem jest zbudowanie algorytmu komputerowego, który może rozróżnić niespójną wersję od oryginału. W tych warunkach niektóre systemy osiągnęły nawet 90 -procentową dokładność. Całkiem imponujące.

Ale z tą metodą jest duża potencjalna wada. Może już to zauważyłeś. Losowe zamawianie zdań może wytwarzać tekst o niskim okresie, ale nie wytwarza tekstu, który wygląda jak cokolwiek, co człowiek naturalnie napisałby.

W Grammarly skupiamy się na rozwiązywaniu rzeczywistych problemów, więc wiedzieliśmy, że każda praca, którą wykonaliśmy w tym obszarze, będą musiały być porównywane przeciwko prawdziwym pisaniu, a nie sztucznym scenariuszom. Co zaskakujące, bardzo mało pracy testuje metody oceny dyskursu w prawdziwym tekście napisanym przez ludzi w zwykłych okolicznościach. Czas to zmienić.

Badania w świecie rzeczywistym, prawdziwi pisarze

Pierwszym problemem, który musieliśmy rozwiązać, był ten sam, z którym napotkał każdy inny badacz pracujący nad spójnością dyskursu: brak rzeczywistych danych. Nie było żadnego korpusu zwykłego, naturalnie napisanego tekstu, na którym mogliśmy przetestować nasze algorytmy.

Stworzyliśmy korpus, zbierając tekst z kilku źródeł publicznych: odpowiedzi Yahoo, recenzje Yelp oraz publicznie dostępne e -maile rządowe i korporacyjne. Wybraliśmy te konkretne źródła, ponieważ reprezentują one rodzaje rzeczy, które ludzie piszą w typowym dniu - na posty, recenzje i e -maile.

Aby przekształcić cały ten tekst w korpus, z którego mogą się uczyć algorytmy komputerowe, musieliśmy również ocenić poziomy spójności każdego tekstu. Proces ten nazywa się adnotacją. Bez względu na to, jak dobry jest twój algorytm, niechlujna adnotacja drastycznie wypaczy twoje wyniki. W naszym artykule podajemy szczegółowe informacje na temat wielu badanych metod adnotacji, w tym niektórych, które obejmowały crowdsourcing. Ostatecznie zdecydowaliśmy się, że adnotatory ekspertów ocenili poziom spójności każdego kawałka tekstu na trzypunktową skalę (niską, średnią lub wysoką spójność). Każdy tekst został oceniony przez trzy adnotatory.

Przekładanie algorytmów na test

Gdy mieliśmy korpus, nadszedł czas, aby dokładnie przetestować, jak dokładnie różne systemy komputerowe mogą zidentyfikować poziom spójności danego tekstu. Przetestowaliśmy trzy rodzaje systemów:

W pierwszej kategorii znajdują się modele oparte na jednostkach. Systemy te śledzą, gdzie i jak często te same podmioty są wymieniane w tekście. Na przykład, jeśli system znajdzie słowo „transport” w kilku zdaniach, traktuje to jako znak, że zdania te są logicznie ze sobą powiązane.

W drugiej kategorii przetestowaliśmy model oparty na wykresie koherencji leksykalnej. Jest to sposób reprezentowania zdań jako węzłów na wykresie i łączenia zdań zawierających pary podobnych słów. Na przykład ten rodzaj modelu połączyłby zdanie zawierające „samochód” i zdanie zawierające „ciężarówkę”, ponieważ oba zdania dotyczą prawdopodobnie pojazdów lub transportu.

W trzeciej kategorii są modele sieci neuronowej lub głębokie uczenie się. Przetestowaliśmy kilka z nich, w tym dwa zupełnie nowe modele zbudowane przez zespół gramatyki. Są to systemy oparte na sztucznej inteligencji, które uczą się reprezentacji każdego zdania, które uchwyci jego znaczenie, i mogą nauczyć się ogólnego znaczenia dokumentu poprzez połączenie tych reprezentacji zdań. Mogą szukać wzorów, które nie są ograniczone do występowania istoty lub podobnych par słów.

Zadanie zamawiania wyroku

Wykorzystaliśmy teksty o wysokim okresie z naszego nowego korpusu, aby stworzyć zadanie zamawiania zdań dla wszystkich trzech rodzajów modeli. Stwierdziliśmy, że modele, które działały dobrze w innych zestawach danych zamawiających zdanie, również działały dobrze na naszym zestawie danych, z wydajnościami nawet 89 -procentową dokładnością. Modele oparte na jednostkach i wykresy spójności leksykalnej wykazały przyzwoitą dokładność (ogólnie od 60 do 70 procent dokładności), ale to modele neuronowe przewyższały pozostałe modele o co najmniej dziesięć punktów procentowych w trzech z czterech domen.

Prawdziwy test pisania

Naprawdę chcieliśmy wiedzieć, czy którykolwiek z tych modeli może działać na tym samym poziomie dokładności prawdziwego, naturalnie pisanego tekstu. Przekształciliśmy etykiety adnotatorów na wartości numeryczne (niski = 1, średnio = 2, wysokie = 3) i uśredniliśmy liczby razem, aby uzyskać wynik spójności dla każdego kawałka tekstu.

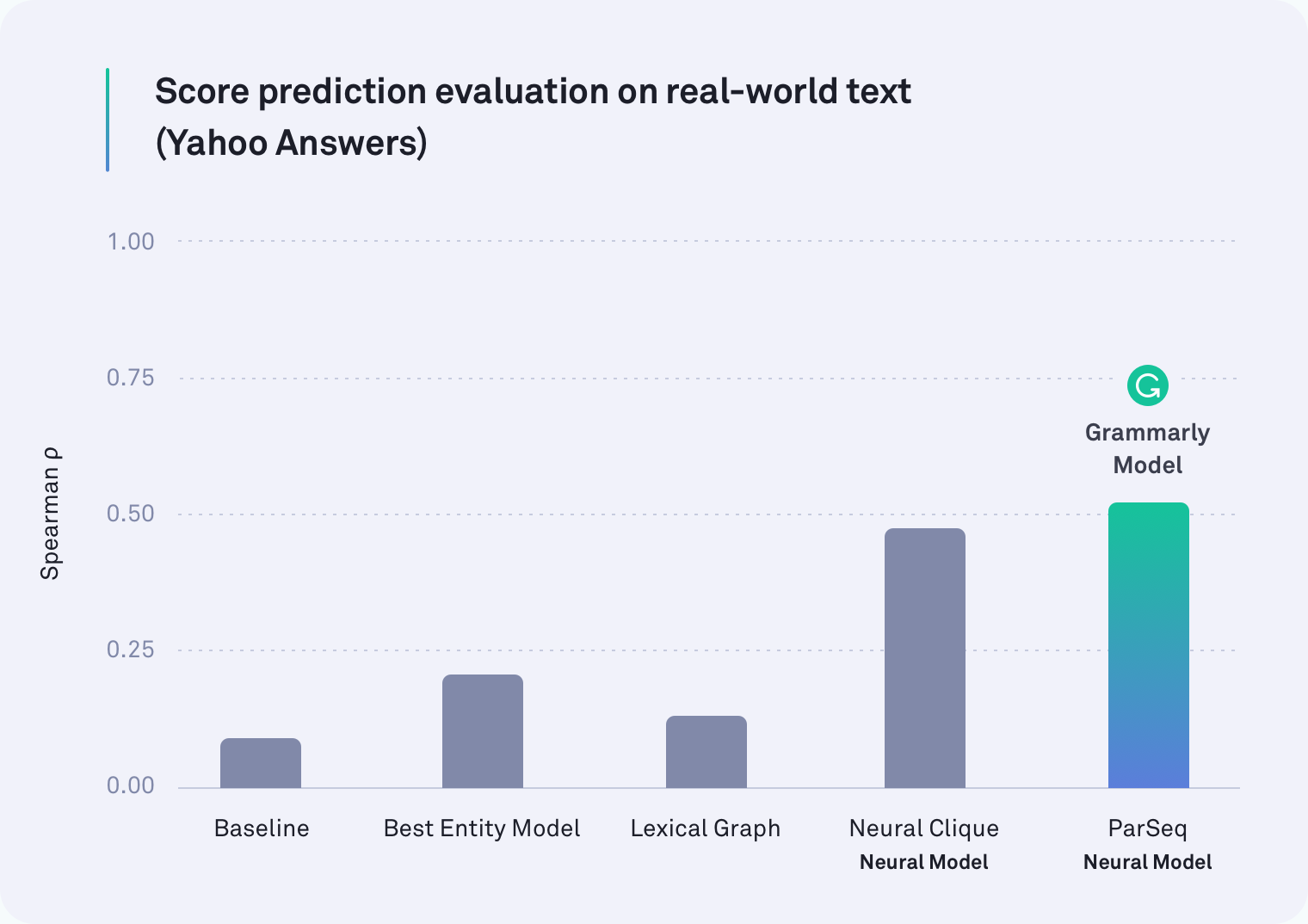

W każdej dziedzinie przynajmniej jeden z systemów sieci neuronowych przewyższył wszystkie pozostałe. W rzeczywistości jednym z modeli Grammarly, które uwzględniają przerwy w akapicie, był najlepszy wykonawca tekstu z odpowiedzi Yahoo, jak pokazano w poniższej tabeli. Model kliki neuronowej, który został opracowany przez naukowców w Stanford, był również silnym wykonawcą.

Ale nasza pierwotna hipoteza była poprawna: wszystkie modele wykonywane gorzej w zadaniu rzeczywistym niż w zadaniu zlecenia zdania-niektóre były znacznie gorsze. Na przykład metoda wykresu leksykalnego była 78 procent dokładna w przypadku e -maili korporacyjnych w scenariuszu ponownego zamawiania zdań, ale udało się osiągnąć 45 procent w tej bardziej realistycznej ocenie.

Co znaleźliśmy

Okazuje się, że poprzednie prace nad spójnością dyskursu testowały niewłaściwą rzecz. Zadanie zamówienia zdania zdecydowanie nie jest dobrym proxy do pomiaru spójności dyskursu. Nasze wyniki są jasne: systemy, które działają dobrze w sztucznym scenariuszu, robią znacznie gorzej w prawdziwym tekście.

Ważne jest, aby pamiętać, że to odkrycie nie jest niepowodzeniem. W rzeczywistości daleko od tego. Częścią uprawy dowolnej dziedziny jest ocena, w jaki sposób oceniasz - od czasu do czasu, aby spojrzeć na to, co naprawdę mierzyłeś. Z powodu tej pracy naukowcy pracujący nad spójnością dyskursu mają teraz dwie ważne informacje. Jednym z nich jest wgląd, że zadanie zamawiania zdań nie powinno już być sposobem, w jaki mierzymy dokładność. Drugi to publicznie dostępny, adnotowany korpus prawdziwego tekstu i nowych testów porównawczych (nasze modele neuronowe) do wykorzystania w przyszłych badaniach.

Oczekiwanie na coś

Jest więcej pracy do zrobienia i wiele ekscytujących aplikacji dotyczących systemu, który może niezawodnie ocenić spójność dyskursu w kawałku tekstu. Pewnego dnia taki system może nie tylko powiedzieć, jak spójny jest twój ogólny komunikat, ale także wskazać konkretne fragmenty, które mogą być trudne do naśladowania. Pewnego dnia mamy nadzieję, że pomogą ci ułatwić zrozumienie tych fragmentów, aby to, co próbujesz powiedzieć, było jasne dla odbiorcy.

W końcu ścieżka Grammarly'ego do zostania kompleksowym asystentem komunikacyjnym nie chodzi tylko o upewnienie się, że twoje pisanie jest dokładne gramatycznie i stylistycznie - chodzi o zapewnienie, że jesteś zrozumiały tak, jak zamierzono.

—--

Joel Tetreault jest dyrektorem badań w Grammarly. Alice Lai jest doktorantką na University of Illinois w Urbana-Champaign i była stażystą badawczą w Grammarly. Badania zostaną zaprezentowane na dorocznej konferencji Sigdial 2018 w Melbourne w Australii, 12-14 lipca 2018 r. Towarzyszący dokument badawczy, zatytułowany „Dyskursowa koherencja na dziczy: zestaw danych, ocena i metody” zostanie opublikowana w postępowaniu z 19. dorocznego spotkania specjalnej grupy interesowej w sprawie dyskursu i dialogu. Zestaw danych opisany w tym poście na blogu nazywa się Grammarly Corpus of Discourse Coherence i można pobrać bezpłatnie do celów badawczych tutaj.