Under the Hood at Grammarly: rilevare la scrittura disorganizzata con AI

Pubblicato: 2018-07-10Ogni volta che scrivi qualcosa di più a lungo di una frase, devi prendere decisioni su come organizzare e presentare i tuoi pensieri. Una buona scrittura è facile da capire perché ogni frase si basa su quelli che sono venuti prima. Quando l'argomento cambia, gli scrittori forti usano frasi di transizione e pause di paragrafo come segni per dire ai lettori cosa aspettarsi dopo.

I linguisti chiamano questo aspetto della scrittura della coerenza del discorso, ed è oggetto di alcune nuove fantastiche ricerche da parte del team di ricerca Grammarly che apparirà alla Conferenza Sigdial di Melbourne, in Australia, questa settimana.

Che cos'è la coerenza del discorso e perché preoccuparsene?

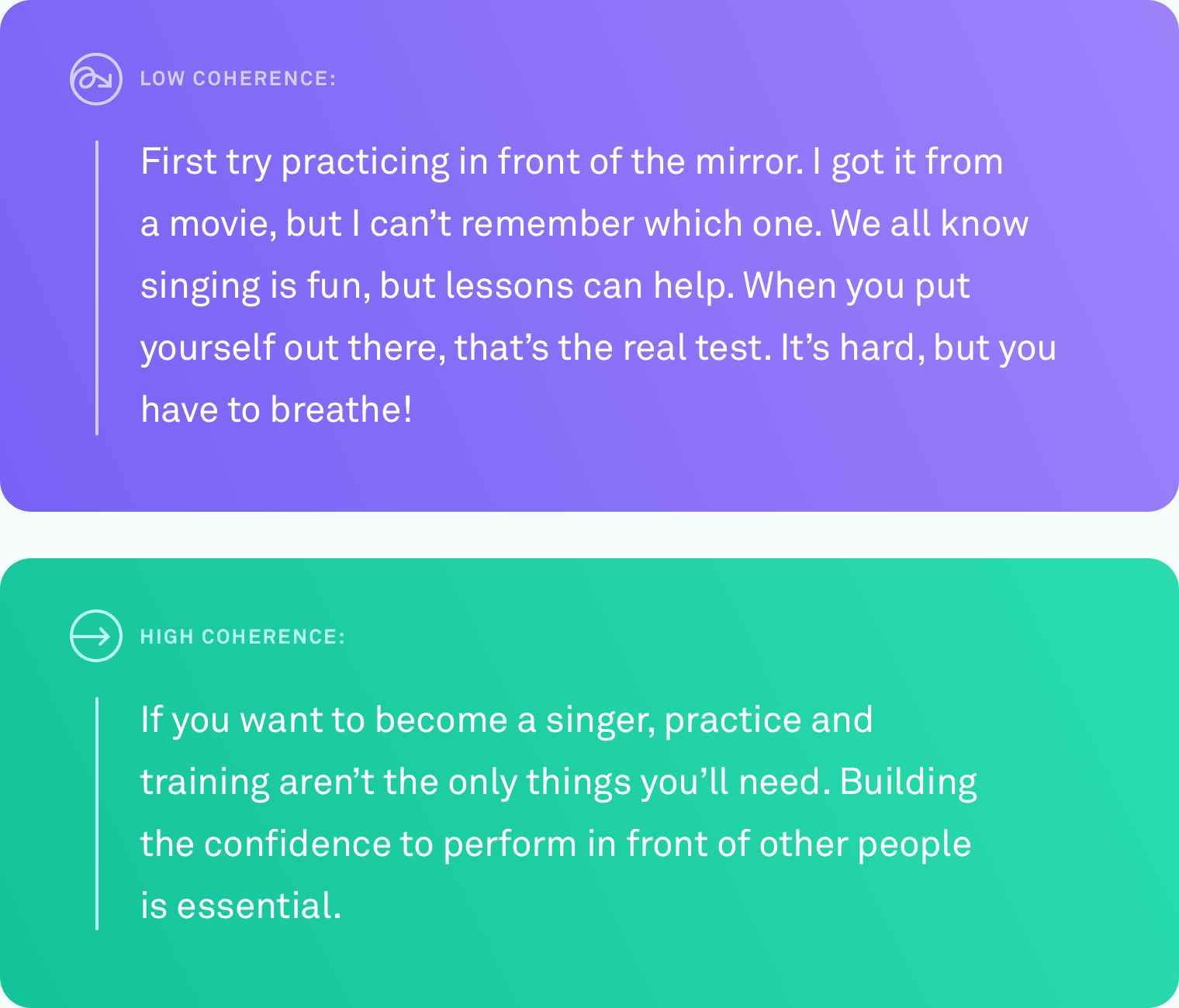

Quando diciamo che un testo ha un alto livello di coerenza del discorso, intendiamo che tutte le frasi sono collegate insieme logicamente. Lo scrittore non si allontana dall'argomento. Punti diversi sono collegati dalle transizioni. Il testo è facile da seguire dall'inizio alla fine.

Questo tipo di organizzazione non è sempre naturale. Pochi di noi pensano in progressioni perfettamente lineari di idee. Un sistema che potrebbe dirti automaticamente quando avrai scritto qualcosa che altre persone faranno fatica a seguire - e, alla fine, suggerire come risolvere questo problema - sarebbe enormemente utile per comunicare ciò che intendi.

Cosa è stato fatto

Insegnare a un computer per giudicare accuratamente il livello di coerenza del testo è impegnativo. Ad oggi, il metodo più comune per valutare la coerenza del discorso sui tassi di un computer si basa su un'attività di ordinamento delle frasi. Con questo metodo, i ricercatori prendono un testo esistente e ben modificato, come un articolo di notizie e riordinano casualmente tutte le frasi. L'ipotesi è che la permutazione casuale può essere vista come incoerente e l'ordinamento originale può essere considerato coerente. L'attività è quella di creare un algoritmo di computer in grado di distinguere tra la versione incoerente e l'originale. In queste condizioni, alcuni sistemi hanno raggiunto la precisione del 90 percento. Abbastanza impressionante.

Ma c'è un grande difetto potenziale con questo metodo. Forse l'hai già individuato. Le frasi di riordino casualmente potrebbero produrre un testo a bassa coerenza, ma non produce testo che assomiglia a qualcosa che un essere umano scriverebbe naturalmente.

In Grammarly, ci concentriamo sulla risoluzione di problemi del mondo reale, quindi sapevamo che qualsiasi lavoro che facevamo in quest'area avrebbe dovuto essere confrontato con la scrittura reale, non gli scenari artificiali. Sorprendentemente, c'è stato pochissimo lavoro che verifica i metodi di valutazione del discorso sul testo reale scritto da persone in circostanze ordinarie. È tempo di cambiarlo.

Ricerca nel mondo reale, scrittori del mondo reale

Il primo problema che abbiamo dovuto risolvere è stato lo stesso che ogni altro ricercatore ha dovuto affrontare la coerenza del discorso: una mancanza di dati del mondo reale. Non esisteva un corpus esistente di testo ordinario e scritto naturalmente su cui potevamo testare i nostri algoritmi.

Abbiamo creato un corpus raccogliendo testo da diverse fonti pubbliche: risposte di Yahoo, recensioni di Yelp e e -mail governative e aziendali disponibili al pubblico. Abbiamo scelto queste fonti specifiche perché rappresentano il tipo di cose che le persone scrivono in un giorno tipico: post, recensioni ed e -mail.

Per trasformare tutto questo testo in un corpus da cui gli algoritmi di computer possono imparare, dovevamo anche valutare i livelli di coerenza di ciascun testo. Questo processo si chiama annotazione. Non importa quanto sia buono il tuo algoritmo, l'annotazione sciatta distorcerà drasticamente i tuoi risultati. Nel nostro documento, forniamo dettagli sui numerosi approcci di annotazione che abbiamo testato, tra cui alcuni che hanno coinvolto il crowdsourcing. Alla fine abbiamo deciso di avere annotatori esperti di valutare il livello di coerenza di ciascun pezzo di testo su una scala a tre punti (bassa, media o alta coerenza). Ogni pezzo di testo è stato giudicato da tre annotanti.

Mettere al test gli algoritmi

Una volta che avevamo il corpus, era tempo di testare quanto accuratamente vari sistemi informatici potessero identificare il livello di coerenza di un determinato pezzo di testo. Abbiamo testato tre tipi di sistemi:

Nella prima categoria ci sono modelli basati sull'entità. Questi sistemi tracciano dove e quanto spesso le stesse entità sono menzionate in un testo. Ad esempio, se il sistema trova la parola "trasporto" in diverse frasi, lo prende come segno che quelle frasi sono logicamente correlate tra loro.

Nella seconda categoria, abbiamo testato un modello basato su un grafico di coerenza lessicale. Questo è un modo per rappresentare le frasi come nodi in un grafico e connettere frasi che contengono coppie di parole simili. Ad esempio, questo tipo di modello collegherebbe una frase contenente "auto" e una frase contenente "camion" perché entrambe le frasi riguardano probabilmente veicoli o trasporti.

Nella terza categoria ci sono modelli neurali o apprendimento profondo. Abbiamo testato molti di questi, tra cui due modelli nuovissimi costruiti dal team Grammarly. Questi sono sistemi basati sull'intelligenza artificiale che apprendono una rappresentazione di ogni frase che ne cattura il significato e possono imparare il significato generale di un documento combinando queste rappresentazioni di frasi. Possono cercare modelli che non siano limitati alle occorrenze di entità o alle coppie di parole simili.

L'attività di ordinazione della frase

Abbiamo usato i testi ad alta coerenza dal nostro nuovo corpus per creare un'attività di ordinamento delle frasi per tutti e tre i tipi di modelli. Abbiamo scoperto che anche i modelli che hanno funzionato bene su altri set di dati di ordinazione delle frasi hanno funzionato bene sul nostro set di dati, con prestazioni fino all'89 % di precisione. I modelli basati sull'entità e i grafici di coerenza lessicale hanno mostrato una precisione decente (generalmente una precisione del 60-70 percento), ma sono stati i modelli neurali che hanno sovraperformato gli altri modelli di almeno dieci punti percentuali su tre dei quattro domini.

Il vero test di scrittura

Quello che volevamo davvero sapere era se uno di questi modelli potesse esibirsi allo stesso livello di accuratezza sul testo reale e naturalmente scritto. Abbiamo convertito le etichette degli annotatori in valori numerici (basso = 1, medio = 2, alto = 3) e abbiamo mediato i numeri per ottenere un punteggio di coerenza per ogni pezzo di testo.

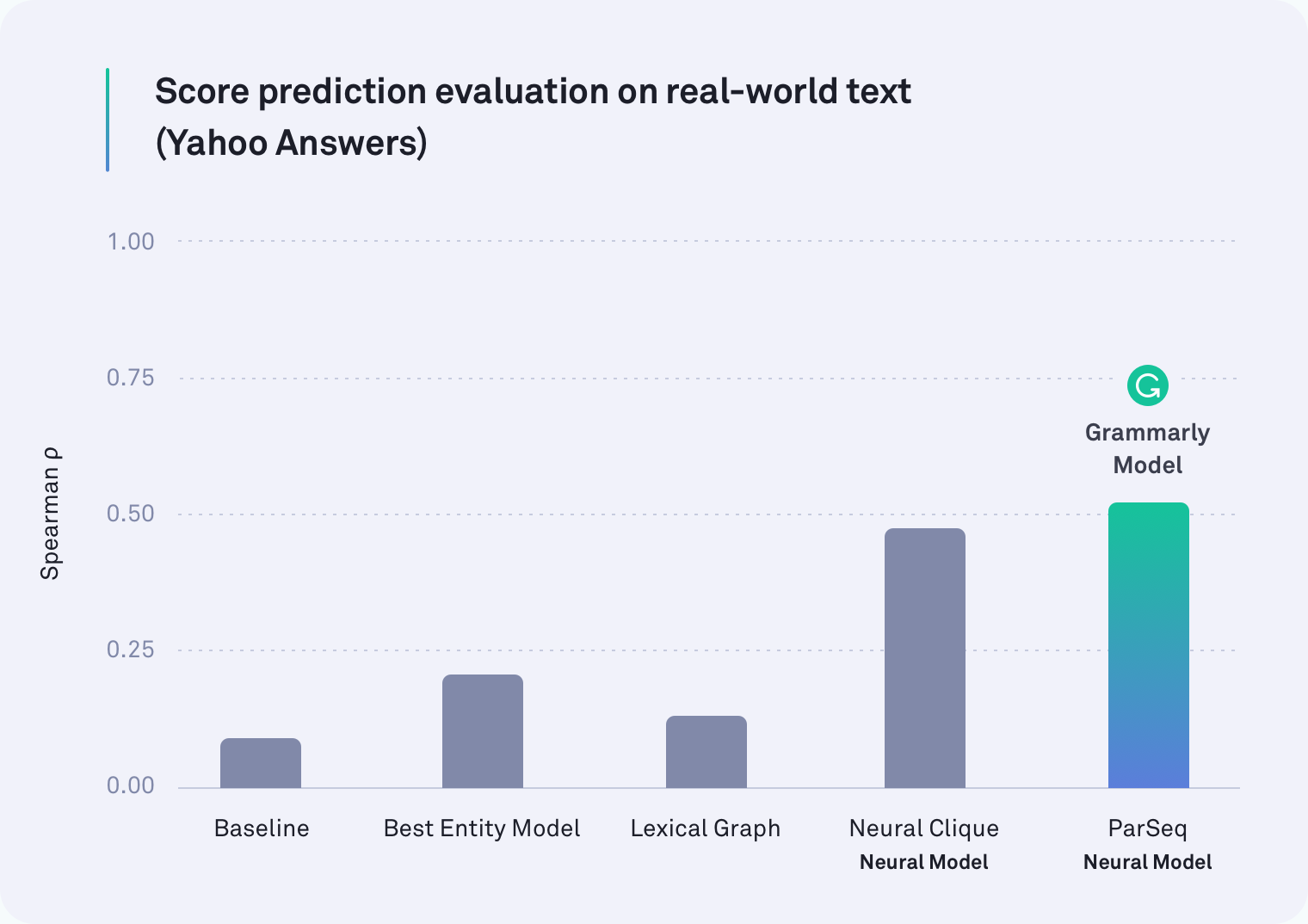

In ogni dominio, almeno uno dei sistemi basati sulla rete neurale ha sovraperformato tutti gli altri. In effetti, uno dei modelli di Grammarly che tiene conto delle rotture di paragrafo è stato il miglior artisti del testo di Yahoo Risposte, come mostrato nella tabella seguente. Anche il modello di cricca neurale, che è stato sviluppato dai ricercatori di Stanford, era un artista forte.

Ma la nostra ipotesi originale era corretta: tutti i modelli hanno ottenuto peggio sul compito del mondo reale di quanto non avessero fatto sull'attività dell'ordine delle frasi: alcuni erano molto peggio. Ad esempio, il metodo del grafico lessicale era accurato del 78 % per le e -mail aziendali nello scenario di riordinaggio della frase artificiale, ma è riuscito a raggiungere solo il 45 % in questa valutazione più realistica.

Quello che abbiamo trovato

Si scopre che i precedenti lavori sulla coerenza del discorso hanno testato la cosa sbagliata. L'attività dell'ordine delle frasi non è sicuramente un buon proxy per misurare la coerenza del discorso. I nostri risultati sono chiari: i sistemi che si comportano bene nello scenario artificiale fanno molto peggio sul testo del mondo reale.

È importante notare che questa scoperta non è una battuta d'arresto. Lontano da esso, in effetti. Parte della coltivazione di qualsiasi campo sta valutando il modo in cui stai valutando, stendendo ogni tanto per dare un'occhiata a ciò che hai veramente misurato. A causa di questo lavoro, i ricercatori che lavorano sulla coerenza del discorso hanno ora due importanti informazioni. Uno è l'intuizione che l'attività di ordinazione della frase non dovrebbe più essere il modo in cui misuriamo l'accuratezza. Il secondo è un corpus annotato pubblicamente disponibile di testo nel mondo reale e nuovi benchmark (i nostri modelli neurali) da utilizzare nella ricerca futura.

In attesa

C'è più lavoro da fare e molte applicazioni entusiasmanti per un sistema in grado di giudicare in modo affidabile la coerenza del discorso in un pezzo di testo. Un giorno, un sistema come questo potrebbe non solo dirti quanto sia coerente il tuo messaggio generale, ma anche indicare i passaggi specifici che potrebbero essere difficili da seguire. Un giorno speriamo di aiutarti a rendere quei passaggi più facili da capire in modo che ciò che stai cercando di dire sia chiaro al tuo destinatario.

Dopotutto, il percorso di Grammarly per diventare un assistente di comunicazione globale non è solo quello di assicurarsi che la tua scrittura sia grammaticamente e stilisticamente accurata, si tratta di garantire che tu sia inteso come previsto.

—-

Joel Tetreault è direttore della ricerca presso Grammarly. Alice Lai è una studentessa di dottorato presso l'Università dell'Illinois a Urbana-Champaign ed è stata stagista di ricerca presso Grammarly. Questa ricerca sarà presentata alla Conferenza annuale Sigdial 2018 a Melbourne, in Australia, 12-14 luglio 2018. Il documento di ricerca di accompagnamento, intitolato "Coerenza del discorso in natura: un set di dati, una valutazione e metodi" sarà pubblicato negli atti del 19 ° incontro annuale del gruppo di interesse speciale sul discorso e sul dialogo. Il set di dati descritto in questo post sul blog è chiamato Grammarly Corpus of Discourse Coherence ed è gratuito da scaricare per scopi di ricerca qui.